[AI 演進史 Part 3] 語言與代理:LLM 引領的 AI Agent 時代

2026年1月11日 · wemee

![[AI 演進史 Part 3] 語言與代理:LLM 引領的 AI Agent 時代](/images/blog/ai-evolution-part3-agency.webp)

在 上一篇 我們見證了 AI 如何學會了「視覺創造」。 但人類智慧的皇冠,始終是「語言」與「邏輯」。

這是 AI 演進史的最後一塊拼圖,也是我們現在正身處其中的巨浪。

Transformer:關注你需要的一切

故事的轉折點發生在 2017 年 Google 發表的論文《Attention Is All You Need》。 這篇論文提出了一個全新的架構:Transformer。

在這個架構之前,我們用 RNN / LSTM 處理語言,像是一步一步地閱讀,讀到後面常常忘了前面。 Transformer 引入了 Self-Attention (自注意力機制),它讓 AI 可以「同時」看到整篇文章的每一個字,並且計算字與字之間的關聯強度。

這就像是給了 AI 一雙「上帝之眼」,它能瞬間理解上下文的複雜關係。這個架構,成為了後來所有 LLM (Large Language Model) 的基石。

規模的暴力美學:從 BERT 到 GPT

接下來的故事就是「大」。 OpenAI 發現了一個簡單粗暴的真理:只要把模型做大,把數據量加倍,AI 就會湧現 (Emerge) 出意想不到的能力。

GPT-1, GPT-2, GPT-3… 參數量從幾億爆增到幾千億。 我們驚訝地發現,當模型大到一定程度時,它不只能接龍寫作,它竟然學會了寫程式、翻譯、甚至做數學題目。

讓 AI 說人話:ChatGPT 與 RLHF

但就算 GPT-3 很強,它講話還是像個機器人,或者像個未經世事的瘋子。 直到 ChatGPT 出現,引入了 RLHF (Reinforcement Learning from Human Feedback)。

簡單說,就是找真人來給 AI 的回答打分數: 「這個回答有禮貌,+1分。」 「這個回答在胡說八道,-1分。」

透過這種強化學習,AI 終於學會了如何「像個人類一樣對話」。這就是所謂的 Alignment (對齊)。

現在,我們每天都在研究這些術語:

- SFT (Supervised Fine-Tuning):教 AI 特定技能。

- Model Merging:把不同的模型像科學怪人一樣縫合起來,試圖融合各家之長。

- Quantization (量化):把模型壓縮,讓它能在你我的筆電上跑起來。

終極型態?AI Agent 與 Antigravity

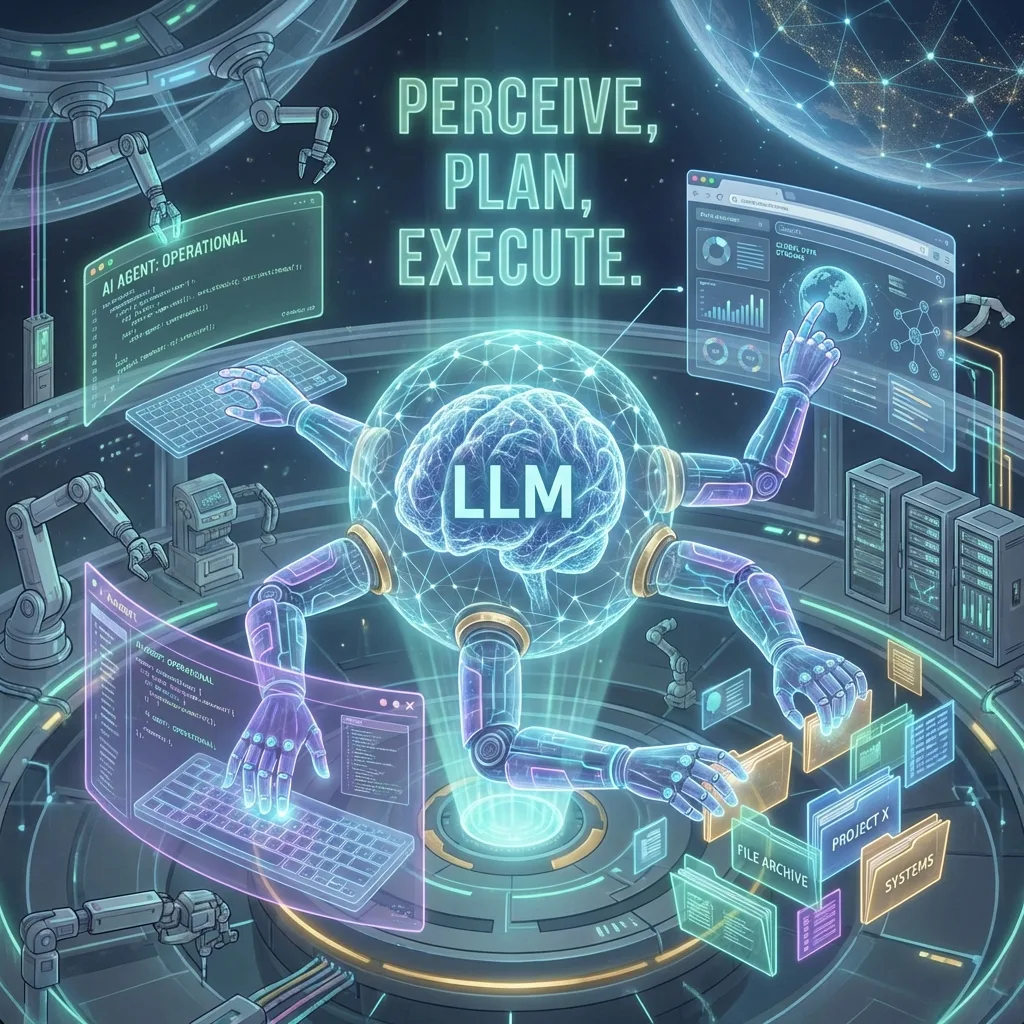

如果說 LLM 是一個超級大腦,那它現在還缺什麼? 它缺「手」和「腳」。它只能在對話框裡打字,不能真的幫你做事。

這就是現在 Google Antigravity 團隊正在做的事情,也是目前 AI 研究的最前線:AI Agent (人工智慧代理)。

我們給 LLM 裝上了工具 (Tools):

- 給它瀏覽器 (Browser),它能幫你上網查資料。

- 給它終端機 (Terminal),它能幫你寫程式、跑測試、部署網站。

- 給它檔案系統 (File System),它能幫你整理文件。

AI 不再只是一個陪聊的機器人,它變成了一個能感知 (Perceive)、規劃 (Plan) 並 執行 (Execute) 的數位員工。

這就是我現在每天在做的事情。

結語:大江東去

回首這 20 年。 從那個在實驗室裡用 SVM 慢慢切分數據點的研究生,到被 CNN 貓狗大戰震撼的工程師,再到現在每天和 AI Agent 協作開發的自己。

SVM -> CNN -> GAN -> Transformer -> Agent

技術的浪潮就像大江東去,一波未平一波又起。當你以為站上了浪頭,下一個更大的浪已經打過來了。 這讓人感到渺小,但也讓人感到無比興奮。

下一個 20 年,AI 會變成什麼樣子?我不知道,但我會繼續看下去。

(全文完)